|

|

![[Photo of the author]](../../common/images/John-Perr.gif)

von John Perr <johnperr(at)linuxfocus.org> Über den Autor: Linux-Anwender seit 1994; einer der französischen Autoren von LinuxFocus; Maschinenbauingenieur, MSc Sound and Vibration Studies Übersetzt ins Deutsche von: Josef Schwarz <josef.schwarz(at)fh-sbg.ac.at> |

Grundlegendes zu Akustik und Signalverarbeitung![[Illustration]](../../common/images/article271/illustration271.png)

Zusammenfassung:

Dieser Artikel bietet Grundlegendes zu Akustik und Signalverarbeitung

für Musiker und Informatiker.. |

Dieser Artikel soll dem Leser ein Grundwissen über Schall (Sound) und Schallverarbeitung geben.

Natürlich wird ein Hauptaugenmerk auf Musik liegen, aber alles in allem ist Musik doch nur

Schall wie jedes andere Geräusch auch, nur eben angenehmer zu hören.

Zuerst werden die physikalischen Konzepte von Schall präsentiert, und die Art und Weise,

wie das menschliche Ohr ihn interpretiert. Dann werden Signale betrachtet, z.B. wie sich Schall

verändert, wenn er aufgenommen wird, besonders mit modernen digitalen Geräten wie Sampler oder Computer.

Zuletzt wird auf aktuelle Kompressionstechnologien wie mp3 oder Ogg vorbis eingegangen.

Die Themen, die in diesem Artikel zur Sprache kommen, sollten einem breiten Publikum verständlich

sein. Der Autor versucht sein Bestes, eine "normale Sprache" zu verwenden und besonders Ausdrücke, die

Musikern vertraut sind. Ein paar wenige mathematische Formeln tauchen hie und da in den Abbildungen auf,

sind hier aber nicht weiter wichtig (puuh! Gott sei Dank...).

Physikalisch gesprochen ist Schall mechanisches Vibrieren von gasförmigen, flüssigen oder festen

Medien. Die Elastizität des Mediums erlaubt dem Schall, sich von der Schallquelle weg als Wellen

auszubreiten, genauso wie die Kreise, die von einem ins Wasser geworfenen Stein ausgehen.

Jedes Mal, wenn ein Objekt vibriert, geht ein kleiner Anteil seiner Energie an die Umgebung

als Schall verloren. Um es gleich zu sagen, Schall kann sich nicht in Vakuum ausbreiten.

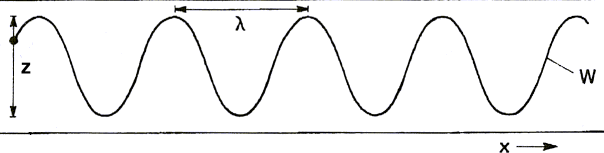

Abbildung 1a zeigt, wie ein Taststift, der mit einer vibrierenden Quelle, z.B. einem Lautsprecher,

verbunden ist, eine Wellenlinie zeichnet, wenn darunter ein Papierband vorbeiläuft.

| z: Vibrierender Taststift mit der Amplitude ±A0 λ: Wellenlänge x: Bandgeschwindigkeit c w: Resultierende Welle Abbildung 1a: Vibrierender Taststift auf einem vorbeilaufenden Papierband |

In der Luft pflanzen sich Schallwellen als Änderungen des Luftdrucks fort. Ein Lautprecher

verursacht Luftdruckänderungen in der umgebenden Luft. Diese (schwachen) Änderungen des Drucks

setzen sich durch die Luft fort. Wichtig ist, dass sich nur der Druck fortpflanzt,

nicht aber die Luft selber. Auch beim Beispiel mit den sich ausbreitenden Kreisen im Wasser,

das ich zuvor angesprochen habe, pflanzen sich nur die Wellen fort, das Wasser bleibt aber

am selben Platz. Ein schwimmendes Objekt bewegt sich nur auf und ab. Das ist auch

der Grund dafür, dass man vor einem Lautsprecher keinen "Wind" verspürt. Schallwellen

pflanzen sich mit etwa 344 Metern pro Sekunde fort, in Luft bei 20°C, aber die

Luftteilchen selbst bewegen sich nur ein paar Mikrometer vor und zurück.

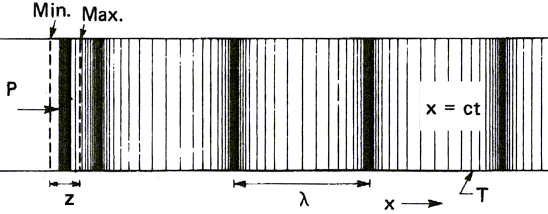

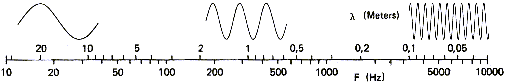

Wir wissen inzwischen aus den obigen Abbildungen, dass Schallwellen eine sinusförmige Form haben.

Der Abstand zwischen zwei Scheitelpunkten wird Wellenlänge genannt und die Anzahl der

Scheitelpunkte, die ein Beobachter in einer Sekunde sieht, ist die Frequenz. Dieser in der

Physik verwendete Begriff ist für einen Musiker nichts anderes als die Tonhöhe. Niedrige Frequenzen

ergeben Basstöne, währenddessen hohe Frequenzen hohe Töne ergeben.

Abbildung 2

zeigt sowohl Frequenz als auch Wellenlänge von Schallwellen, die sich in Luft ausbreiten:

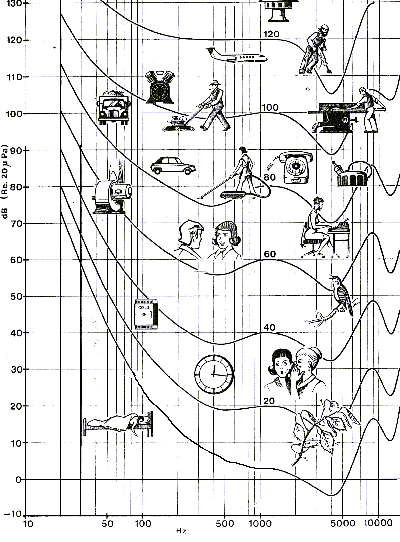

Ein anderes Merkmal von Schall ist seine Amplitude. Schall kann leise oder laut sein. Das entspricht kleinen oder großen Schwankungen des Luftdrucks, je nach der Kraft, mit der die Luft zusammengedrückt wird. Um die Stärke von Schall (Schalldruck) zu bewerten, wird die Einheit Dezibel (dB) verwendet. Dezibel scheint eine eher schwierige Einheit zu sein, wie Abbildungen 3a und 3b zeigen. Es wurde gewählt, weil sich damit nichtsdestotrotz einfach rechnen lässt, und weil der Logarithmus dem menschlichen Hörverhalten entspricht, wie wir im nächsten Kapitel sehen werden. Ganz ohne Zweifel verwenden wir beim Hören Mathematik, ohne es zu merken:

| Abbildung 3a: Schalldruck | Abbildung 3b: Leistungspegel |

Bis jetzt müssen wir nur wissen, dass dB sich auf den Leistungspegel

beziehen. 0 dB entsprechen der unteren menschlichen Hörschwelle und sagen nicht aus, dass

kein Schall vorhanden wäre. Dezibel ist eine Maßeinheit für Schall, die den

menschlichen Wahrnehmungsgrenzen entspricht. Änderungen des Bezugspunktes (Po

oder Wo) ändern dementsprechend den dB-Wert. Darum entspricht die dB-Angabe

am Lautstärkeregler des HiFi-Verstärkers nicht dem Geräuschpegel, sondern der

elektrischen Ausgangsleistung des Verstärkers.

Das ist also eine komplett andere Maßeinheit, da 0 dB oft die maximale

Ausgangsleistung des Verstärkers bezeichnet. Akustisch betrachtet ist die

Lautstärke viel größer, sonst hättest du dir wohl nicht diesen besonderen

Verstärker gekauft, aber es hängt auch von der Effizienz der Lautsprecher ab...

Abbildung 4 zeigt uns Amplitude und Frequenz verschiedener, bekannte Schallquellen.

Die geschwungenen Linien verbinden, was das menschliche Gehör als gleich laut

empfindet; darauf werden wir später noch genauer eingehen:

Die nachstehende Tabelle zeigt Pegel verbreiteter Schallquellen in Dezibel und Watt. Achte darauf, wie die Verwendung von Dezibel als Einheit die Notation vereinfacht.

| Leistung (Watt) | Pegel dB | Beispiel | Leistung (W) |

|---|---|---|---|

| 100 000 000 | 200 | Saturn V Rakete 4 Duesenflugzeuge |

50 000 000 50 000 |

| 1 000 000 | 180 | ||

| 10 000 | 160 | ||

| 100 | 140 | Großes Orchester | 10 |

| 1 | 120 | Meißelhammer | 1 |

| 0.01 | 100 | Sprache: Schreien | 0.001 |

| 0.000 1 | 80 | ||

| 0.000 001 | 60 | Sprache: Unterhaltung | 20x10-6 |

| 0.000 000 01 | 40 | ||

| 0.000 000 000 1 | 20 | Sprache: Flüstern | 10-9 |

| 0.000 000 000 001 | 0 | ||

| Schalldruck einiger typischer Schallquellen | |||

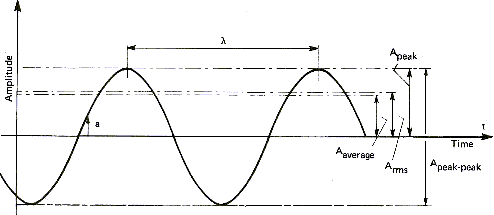

Die Schallamplitude kann auf verschiedene Weise gemessen werden. Das gilt auch für andere Wellensignale wie Abbildung 5 zeigt:

| Symbol | Name | Definition |

|---|---|---|

| ADurchschnitt | durchschnittliche Amplitude | arithmet. Mittel des positiven Signalteils |

| ARMS | quadrat. Mittelwert | Amplitude proportional zum Energieinhalt |

| AScheitelwert | höchste Amplitude | maximale positive Amplitude |

| Adoppelter Scheitelwert | Amplitude des doppelten Scheitelwerts | maximale positive bis negative Amplitude |

Die durchnittliche Amplitude ist nur eine theoretische Maßzahl, die technisch nicht verwendet wird. Der quadratische Mittelwert wird hingegen allgemein verwendet, um äquivalente Signale und im Besonderen Sinuswellen zu messen. Zum Beispiel ist die Spannung, die bei uns mit 220 Volt aus der Steckdose kommt, eigentlich eine Sinuswelle mit einer Frequenz von 50 Hertz (Hz). Dabei sind die 220 Volt der quadratische Mittelwert, so dass der Wert eigentlich zwischen -311 Volt und -311 Volt schwingt. Wenn wir die andere Definition verwenden, dann hat das Signal einen Scheitelwert von 311 Volt oder 622 Volt doppelten Scheitelwert. Dieselben Definitionen werden für das Ausgangssignal des Verstärkers verwendet, das zu den Lautsprechern führt. Ein Verstärker, der 10 Watt in quadrat. Mittelwert liefert, erreicht damit einen Scheitelwert von 14 Watt und einen doppelten Scheitelwert von 28 Watt. Im Handel wird für die Leistung eines Verstärkers gerne der doppelte Scheitelwert propagiert, weil er natürlich höher ist und imposanter klingt.

Zeit spielt eine gewichtige Rolle in der Akustik.

Zeit und Raum sind sehr eng miteinander verknüpft, da Schall

eine Welle ist, die sich über die Zeit im Raum fortpflanzt.

Wenn man das bedenkt, kann man drei Arten von akustischen

Signalen definieren:

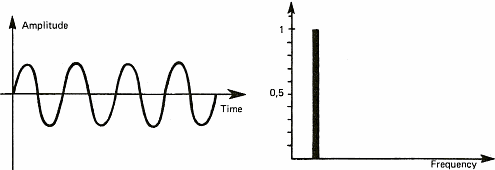

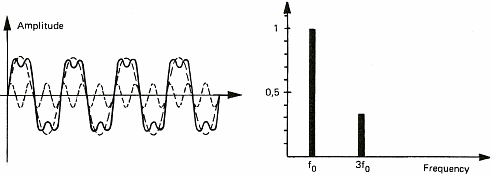

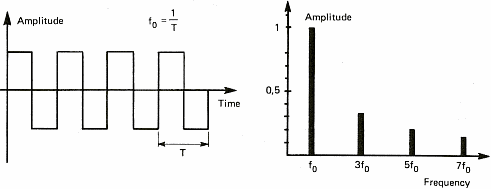

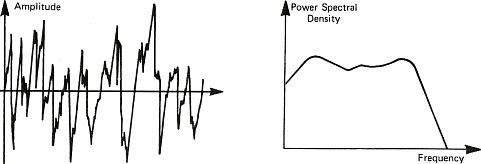

Die Diagramme in Abbildung 6 zeigen ein paar Tonsignale. Wir verwenden diese Diagramme, um den Begriff des Spektrums zu veranschaulichen. Das Spektrum eines Signals zeigt die unterschiedlichen Frequenzen, also Tonhöhen, die gemeinsam einen komplexen Klang ausmachen. Wenn wir ein stabiles periodisches Signal betrachten (gleichbleibender Ton), ist das Spektrum über die ganze Zeitspanne stabil und zeigt nur einen Wert (ein einzelner Strich in Abbildung 6a rechts). Man kann jeden Klang als eine Zusammensetzung mehrerer Töne, also Sinuswellen, sehen. Wir werden später sehen, dass dieses "Aufsplitten" eines periodischen Signals in lauter Sinuswellen zum ersten Mal im 19. Jahrhundert von einem französischen Mathematiker namens Fourier gezeigt worden ist. Diese Erkenntnis wird uns auch erlauben, auf Akkorde einzugehen. In der Zwischenzeit möchte ich aber bei Sinuswellen bleiben, weil die viel einfacher zu zeichnen sind, als Solos von Jimmy Hendrix...

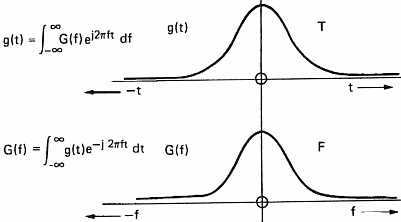

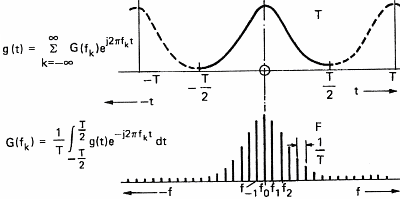

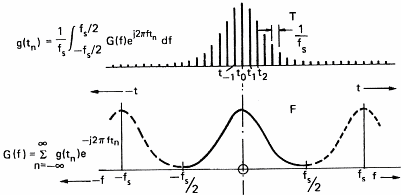

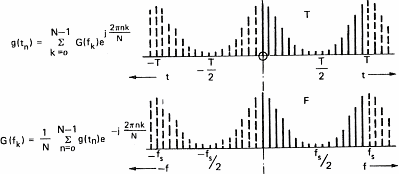

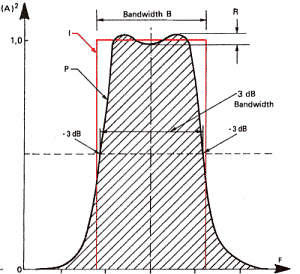

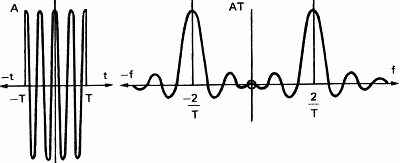

Um Schall mit einem Computer verarbeiten zu können, müssen wir ihn aufnehmen, d.h. wir verwandeln die Veränderungen des Luftdrucks in eine Reihe von Zahlen, die der Computer dann versteht. Man verwendet dazu ein Mikrophon, das Luftdruckänderungen in ein elektrisches Signal verwandelt. Dieses Signal wird dann regelmäßig abgetastet (gesampelt) und der momentane Wert des Signals als Zahl gespeichert. Sampler ist ein allgemeinerer Begriff, und von Elektronikern wird oft der Begriff ADC (Analog to Digital Converter) verwendet. Sampling finden wir auch bei der Soundkarte des PCs. Die Geschwindigkeit, mit der die Soundkarte das Eingangssignal pro Sekunde abtastet und als Zahlen abspeichert (=digitalisiert), wird Abtastfrequenz genannt. Abbildung 7 zeigt den Einfluss der Abtastfrequenz auf ein Signal und sein Spektrum, das mit Hilfe der Fouriertransformation berechnet wurde. Für die Mathe-Junkies unter uns gibts hier ein paar Formeln:

Das zeigt uns (bitte glaub mir), dass die Transformation einer

kontinuierlichen Welle in eine Reihe diskreter Werte das

Spektrum periodisch macht. Ist das Signal ebenfalls periodisch,

dann wird das Spektrum ebenfalls diskret (eine Anzahl von Werten)

und wir brauchen nur mehr mit einer endlichen Anzahl von

Frequenzen zu rechnen. Das sind gute Neuigkeiten, weil unser

Computer nur mit Zahlen und Werten rechnen kann, und nicht mit

Wellen.

Im Fall der Abbildung 7d ist das Signal sowohl im Zeit- als auch

im Frequenzbereich diskret, im Zeitbereich periodisch und im

Frequenzbereich nur zwischen 0 Hz und der halben Abtastfrequenz.

Mit dem übergang vom kontinuierlichen zum diskreten Signal

gehen letztendlich Teile des ursprünglichen

Klangsignals verloren. Der Computer kennt das Klangsignal nur

zu den Abtastzeitpunkten. Um sicherzugehen, dass keine großen Verfälschungen

auftreten, müssen wir beim Abtasten ein paar Dinge berücksichtigen.

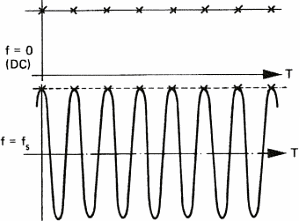

Zum ersten müssen wir sicherstellen, dass das Klangsignal keine

Frequenzen enthält, die höher als die halbe Abtastfrequenz sind.

Wenn man das vergisst, werden diese höheren Frequenzen als

tiefere interpretiert, und das klingt nicht schön. Abbildung 8

verdeutlicht uns das:

Dieses spezielle Verhalten von abgetasteten Signalen ist als das Shannon'sche Abtasttheorem bekannt, benannt nach dem Mathematiker, der dieses Phänomen als erster beschrieben hat. Ein ähnlicher Effekt kann in Filmen, etwa Western, beobachtet werden. Dabei scheinen sich Wagenräder oft rückwärts zu drehen, was am Stroboskop-Effekt von Filmen liegt. Für die praktische Anwendung des Musik-Digitalisierens heißt das, dass man alle Frequenzen oberhalb der halben Abtastfrequenz loswerden muss. Tut man das nicht, wird der Originalton stark verfälscht. Wenn man z.B. die Abtastfrequenz der Compact Disc betrachtet (44.1 KHz), darf es keine Frequenzen oberhalb von 22 kHz geben. (Sag den Fledermäusen im Haus, sie sollen ruhig sein, die reden nämlich mit Ultraschall...).

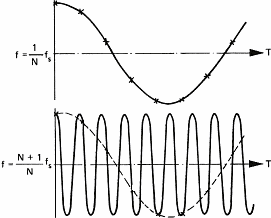

Um die ungewollten Frequenzen loszuwerden, verwendet man Filter. Filter ist ein weitverbreiteter Begriff, der für alles verwendet wird, was bestimmte Klangkomponenten herausheben oder umwandeln kann. So verwendet man etwa einen Tiefpassfilter, um hohe Frequenzen zu unterdrücken, die wir zwar nicht hören können, die aber beim Abtasten lästig sind (das Traschen der Fledermäuse also). Ohne jetzt näher darauf einzugehen, zeigt das folgende Diagramm die Eigenschaften eines Filters:

Ein Filter verändert das Signal sowohl im Zeit- als auch

im Frequenzbereich. Eine 100 Hz Rechteckwelle, in der Frequenzen

ab 200 Hz weggefiltert werden, wird zur Sinuswelle, weil der obere

Teil des Spektrums entfernt wurde (siehe Abbildung 6c). Ähnlich

wird ein Klavierton von 1000 Hz, der bei 1200 oder 1500 Hz gefiltert

wird, ganz anders klingen. Die niedrigste Frequenz eines Signals wird

Grundfrequenz genannt, die anderen sind Vielfache davon und werden

harmonische Frequenzen genannt.

Im Zeitbereich verursacht ein Filter Veränderungen der Welle, die

man Verzerrungen nennt. Das wird hauptsächlich durch die Verzögerung jeder Harmonie relativ zu den anderen,

verursacht.

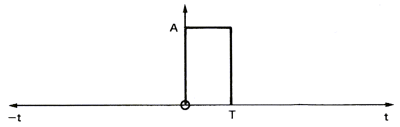

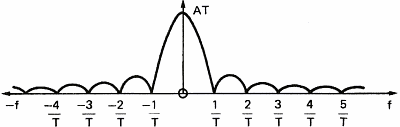

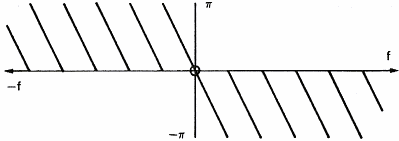

Um den Einfluss eines Filters auf ein Signal zu zeigen, betrachten wir einmal einen einfachen Rechteckimpuls (Abbildung 10a), die Amplitude seines Spektrums im Frequenzbereich (Abbildung 10b) und die Phase seines Spektrums (Abbildung 10c). Dieser Rechteckimpuls arbeitet wie ein Filter, der nur Signale zwischen t=0 and T Sekunden durchlässt. Das Spektrum des Impulses stellt die Frequenzantwort des Filters dar. Wir sehen, dass eine höhere Frequenz des Signals zu einer größeren Verzögerung zwischen den Frequenzkomponenten führt, und zu einer niedrigeren Amplitude.

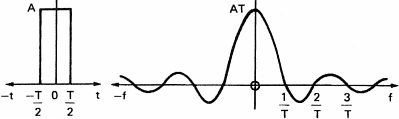

Abbildung 11 zeigt den Einfluss des Rechteckfilters auf ein einfaches Signal wie eine Sinuswelle

Wenn man den Klang abrupt beim Zeitpunkt T abschneidet, führt das zur Bildung neuer Frequenzen im Spektrum der Sinuswelle. Wenn das gefilterte Signal komplexer ist, wie etwa die Rechteckwelle von Abbildung 6c, werden Frequenzkomponenten zurückbleiben und zu einem verzerrten Signal am Ausgang des Filters führen.

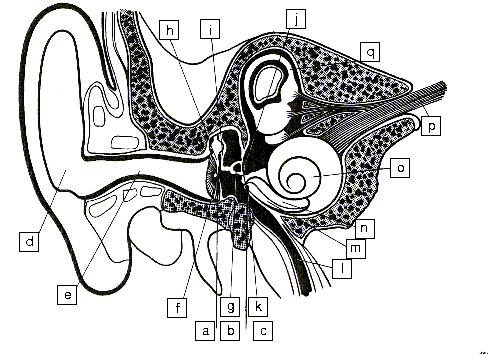

Um ein besseres Verständnis von Akustik und Schall zu bekommen, beschäftigen

wir uns doch mal mit dem Teil, den wir dabei am meisten brauchen, dem Ohr.

Abbildung 12 zeigt einen Querschnitt des Ohrs. Schall wird in der Ohrmuschel

aufgefangen und gelangt durch den Hörkanal zum Trommelfell, das mehr oder weniger

wie ein Mikrofon arbeitet. Die Vibrationen des Trommelfells werden von drei

kleinen Knöchelchen, die wie Hebel wirken, verstärkt. Sie heißen Hammer,

Amboss und Steigbügel.

|

a) Äußeres Ohr b) Mittelohr c) Inneres Ohr d) Ohrmuschel e) Hörkanal f) Trommelfell g) Steigbügel h) Malleus i) Amboss j) Oval Window k) Round Window l) Ohrtrompete m) Paukentreppe n) Scala vestibuli o) Schnecke p) Gehör- und Gleichgewichtsnerv q) Bogengänge des Gleichgewichtsorgans |

|

| Abbildung 12: Die wichtigsten Teile des Ohrs | ||

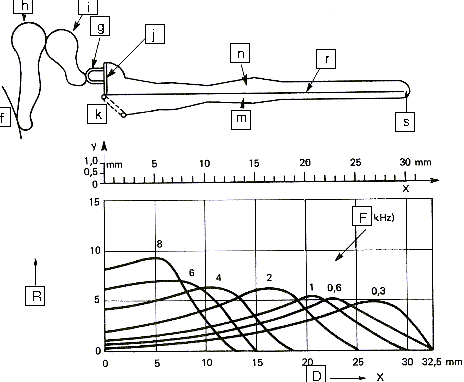

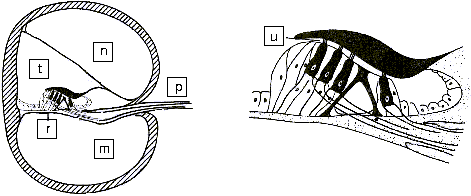

Die Bewegungen des Steigbügel-Knochens werden über das Oval Window zur Ohrschnecke übertragen. Die Schnecke enthält zwei Kammern, getrennt durch die Basilarmembran, die mit empfindlichen Haaren bedeckt ist und mit dem Hörnerv verbunden ist (wie Abbildung 13 und 14 unten zeigen). Die Basilarmembran hilft bei der Wahrnehmung des Schalls, weil die unterschiedlichen Teile der Hörschnecke auf verschiedene Frequenzen mehr oder weniger empfindlich sind. Das erlaubt dem Gehirn, die Tonhöhe von Noten zu unterscheiden.

|

f) Trommelfell g) Steigbügel h) Hammer i) Amboss j) Oval Window k) Round Window m) Paukentreppe n) Scala Vestibuli r) Basilarmembran s) Helicotrema R) Relative Antwort F) Frequenzantwort D) Distance along membrane |

|

| Abbildung 13: Längsschnitt der Hörschnecke | ||

|

m) Paukentreppe n) Scala vestibuli p) Hörnerv r) Basilarmembran t) Scala media u) Haarzelle |

|

| Abbildung 14: Querschnitt der Hörschnecke | ||

Das Gehirn spielt eine sehr wichtige Rolle, weil es für die gesamte

Auswertung des Schalls sorgt. Es macht es möglich, dass wir Geräusche

und Klänge erkennen, je nach Tonhöhe und Dauer. Das Gehirn ermöglicht

auch räumliches Hören, indem es die Signale beider Ohren vergleicht.

Es ermöglicht uns, Musikinstrumente oder Menschen zu erkennen, und

ihre räumliche Position festzustellen. Es scheint, dass die meiste

Arbeit, die das Gehirn leistet, angelernt wurde.

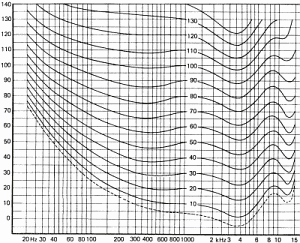

Abbildung 15 zeigt, wie wir Schall abhängig von der Frequenz hören.

Diese Kurven wurden für die Durchschnittsbevölkerung ermittelt, sind ein statistischer Mittelwert für Menschen zwischen 18 und 25 Jahren und gelten für reine Töne. Unterschiede zwischen Personen können durch viele Faktoren erklärt werden, z.B.:

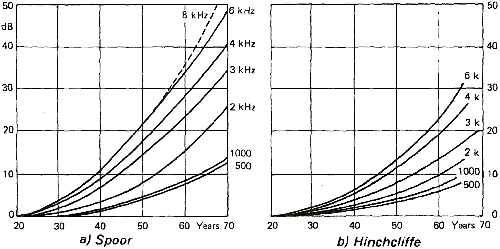

Abbildung 16 zeigt den Einfluss des Alters auf die Fähigkeit, hohe Frequenzen wahrzunehmen. Auf die Quellen bezogen sind die Ergebnisse recht unterschiedlich. Das kann leicht erklärt werden durch große Unterschiede in der Bevölkerung und weil solche Studien nicht einfach nur das Alter in Betracht ziehen. Nicht selten findet man schon etwas ältere Musiker mit "junggebliebenen" Ohren, genauso wie es junge Menschen mit beträchtlichen Gehörschäden gibt. Gründe für frühe Hörschäden sind dabei oft zu lange Konfrontation mit Schall in extremer Lautstärke, etwa in Konzerten oder Diskotheken.

Ob extreme Schalleinwirkung das Gehör dauerhaft verschlechtert, hängt

sowohl von der Dauer als auch von der Lautstärke ab. Wichtig ist,

dass jede Form von Schall schädlich sein kann. Laute Musik mit

dem Kopfhörer hat dieselben Auswirkungen auf die Hörzellen wie

der Rasenmäher oder ein startendes Flugzeug.

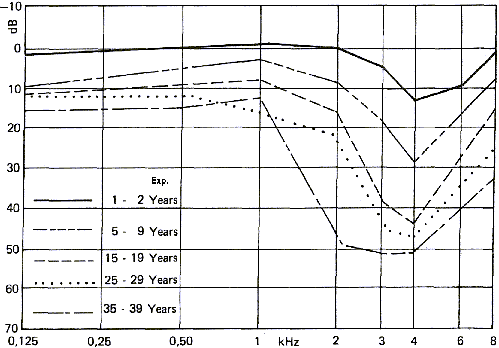

Abbildung 17 zeigt die Auswirkung von extremer Schalleinwirkung

auf das Gehör. Beachte, dass dieser Effekt nicht derselbe ist wie

der durch das Altern verursachte Gehörverlust. Dabei kann das

Ohr hohe Frequenzen schlechter wahrnehmen. Extreme Schalleinwirkung

aber vermindert das Hörvermögen für Frequenzen von 3-4 KHz. Bei diesen

Frequenzen ist das gesunde Ohr am empfindlichsten. Diese Art

von Gehörschädigung findet man oft bei Benutzern von Schusswaffen.

Wenn wir Blick auf das Kapitel über Dezibel (und wie man´s berechnet),

werfen, sehen wir, dass schon zehn Dezibel einen sehr großen

Unterschied im Schalldruck ausmachen. Die lineare Dezibelskala

entspricht nämlich einer exponentiellen Skala des Schalldrucks.

Grund dafür ist, dass Ohr und Gehirn Schall von sehr unterschiedlicher

Amplitude und Frequenz verarbeiten können. Die höchste Frequenz, die

der gesunde Mensch hören kann, ist 1000 Mal höher als die niedrigste,

und der lauteste Ton hat einen eine Million Mal höheren Schalldruck

als der leiseste Ton, den wir zu hören imstande sind

(ein Intensitätsverhältnis von 1012

to 1).

Den Schalldruck zu verdoppeln entspricht gerade mal 3 dB. Das kann man

zwar hören, aber es braucht 9 dB, um dem Menschen den subjektiven Eindruck von

doppelter Lautstärke zu vermitteln. Dabei ist aber der Schalldruck

8 Mal höher!

Im Frequenzbereich entspricht ein Wechsel der Oktave dem Verdoppeln

der Frequenz. Auch hier hören wir den eigentlich exponentiellen

Anstieg der Frequenz auf lineare Art und Weise - ein physikalisches

Phänomen. Greif noch nicht zum Taschenrechner, die Tonhöhen der Noten

werden wir später berechnen.

Aufnahmen mit einem analogen Gerät wie einem Kassettenrecorder sind nach wie vor gebräuchlich, auch wenn sie langsam von digitalen Systemen verdrängt werden. In beiden Fällen führt die Umsetzung der Schallwelle in magnetische Schwingungen oder digitale Daten zu Veränderungen des Signals, was an den Grenzen des aufnehmenden Gerätes liegt. Wir haben schon kurz darüber gesprochen, wie sich das Abtasten eines Signals auf sein Spektrum auswirkt. Ähnliche Effekte sieht man, wenn man ein Signal aufnimmt:

"Dynamik" bezeichnet die Differenz zwischen der kleinsten

und größten Amplitude, die ein Aufnahmegerät erfassen kann.

Das beginnt im Allgemeinen mit dem Mikrophon, das Schall in

ein elektrisches Signal konvertiert, und endet mit dem verwendeten

Aufnahmemedium, der CD, der Kassette oder dem Computer...

Erinnern wir uns daran, dass Dezibel ein Verhältnis angeben.

Im Dynamikbereich bezeichnet 0 dB also den unteren Grenzwert.

Ein paar Beispiele:

Ein Orchester kann bis zu 110 dB erreichen. Das ist auch der Grund dafür, dass Aufnahmetechniker Systeme verwenden, die den Dynamikbereich komprimieren können, sodass Teile mit hoher Lautstärke nicht abgeschnitten werden und leisere nicht im Hintergrundrauschen verloren gehen.

Aufnahmegeräte sind weniger leistungsfähig als das menschliche Ohr und haben den zusätzlichen Nachteil, selbst Geräusche zu produzieren. Das kann Kratzen des Tonabnehmers an der Vinylschallplatte sein, oder auch ein Summen des Verstärkers. Diese Geräusche sind zwar meist sehr leise, aber sie erlauben es uns nicht, leiseste Klänge aufzunehmen. Man hört es am besten, wenn man Kopfhörer von guter Qualität verwendet und es klingt wie ein Wasserfall, da es ein sehr weites Spektrum mit vielen Frequenzen enthält.

Früher haben wir gesehen, dass Filter einen wichtigen Effekt

auf die Phase eines Spektrums haben, weil sie Signale je nach

Frequenz verschieben. Diese Art der Signalverzerrung nennt man

harmonische Verzerrung, weil es alle harmonischen Frequenzen

eines Signals betrifft.

Jedes einzelne Aufnahmegerät verhält sich wie ein Filter und

induziert Signalverzerrungen. Natürlich passiert dasselbe bei der

Wiedegabe, wo zusätzliche Verzerrungen und Rauschen dazukommen.

Mehr und mehr verwendet man Komprimierungsalgorithmen wie mp3

oder Ogg Vorbis, um wertvollen Plattenplatz am Aufnahmemedium

zu sparen.

Man sagt, dass diese Algorithmen verlustbehaftet sind,

weil sie Teile des Signals entfernen, um die Dateigröße zu minimieren.

Komprimierungsalgorithmen benutzen ein Computermodell des menschlichen

Ohrs, um unhörbare Information zu löschen. Zum Beispiel kann man

im Frequenzbereich bei zwei eng benachbarten Frequenzen, die in der

Lautstärke sehr unterschiedlich sind, die leisere Frequenz löschen,

weil sie von der lauten übertönt wird.

Hörtests und Ratschläge, wie man solche Software verwendet, um den

besten Teil des Signals zu erhalten, findet man im Internet.

Soweit der Autor informiert ist, verwendet mp3

einen Tiefpass-Filter, der Frequenzen größer 16 KHhz wegfiltert,

und sie erlauben keine Bitraten größer als 128 KiloBits/Sekunde.

Mit diesen Zahlen lässt sich meist keine CD Qualität erreichen.

Komprimierungsverfahren wie gzip, bzip2, lha oder zip verändern

hingegen keine Daten, erreichen aber dafür keine so hohen

Kompressionsraten. Ausserdem ist es nötig, die ganze Datei zu

entpacken, bevor man sie hören kann, was man bei einem Walkman

oder einem handelsüblichen Abspielgerät wohl kaum gebrauchen kann.

Um einen Ausgleich zu schaffen, folgt hier ein Vergleich von Begriffen aus der Musik und der Technik. Meist hinken diese Vergleiche, denn die Begriffe, die Musikliebhaber verwenden, beschreiben menschliche Eindrücke und nicht physische Phänomene.

Eine Note ist u.a. durch seine Tonhöhe definiert, und diese Tonhöhe ist gleichzeitig die Grundfrequenz der Note. Wenn man das weiß, kann man die Frequenzen einer Note mit der folgenden Formel berechnen:

Wenn wir für REF A mit 440 Hz von der Oktave 4 als Basis einsetzen, können wir die anderen Frequenzen für Töne von 1 bis 12 von C bis B berechnen:

| Note | Oktave | |||||||

|---|---|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | 6 | 7 | 8 | |

| C | 32,70 | 65,41 | 130,8 | 261,6 | 523,3 | 1047 | 2093 | 4186 |

| C # | 34,65 | 69,30 | 138,6 | 277,2 | 554,4 | 1109 | 2217 | 4435 |

| D | 36,71 | 73,42 | 146,8 | 293,7 | 587,3 | 1175 | 2349 | 4699 |

| E b | 38,89 | 77,78 | 155,6 | 311,1 | 622,3 | 1245 | 2489 | 4978 |

| E | 41,20 | 82,41 | 164,8 | 329,6 | 659,3 | 1319 | 2637 | 5274 |

| F | 43,65 | 87,31 | 174,6 | 349,2 | 698,5 | 1397 | 2794 | 5588 |

| F # | 46,25 | 92,50 | 185,0 | 370,0 | 740,0 | 1480 | 2960 | 5920 |

| G | 49,00 | 98,00 | 196,0 | 392,0 | 784,0 | 1568 | 3136 | 6272 |

| A b | 51,91 | 103,8 | 207,6 | 415,3 | 830,6 | 1661 | 3322 | 6645 |

| A | 55,00 | 110,0 | 220,0 | 440,0 | 880,0 | 1760 | 3520 | 7040 |

| B b | 58,27 | 116,5 | 233,1 | 466,2 | 932,3 | 1865 | 3729 | 7459 |

| B | 61,74 | 123,5 | 246,9 | 493,9 | 987,8 | 1976 | 3951 | 7902 |

Der wahre Musikliebhaber wird bemerken, dass wir nicht

zwischen diatonischen und chromatischen Halbtönen unterscheiden.

Mit minimalen Änderungen kann man dieselben Berechnungen mit

Kommas als Unterteilung anstatt von Halbtönen durchführen...

Um zu unterscheiden, mit welchem Instrument ein Ton gespielt

wurde, reicht es nicht, nur davon auszugehen, dass jeder Ton aus

verschiedenen Frequenzen besteht... Man muss auch in Betracht

ziehen, wie der Ton gespielt wird (pizzicato oder legato), von

welchem Instrument es kommt, ganz abgesehen von alle möglichen

Effekten wie glissando, vibrato, etc... Für diesen Zweck kann

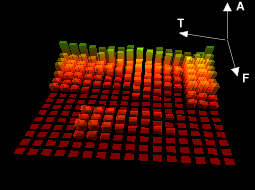

man das Sonogramm eines Tons untersuchen, d.h. Veränderungen

des Spektrums durch die Zeit. Ein Sonogramm erlaubt es, alle

harmonischen Frequenzen über die Zeitachse zu sehen.

| Abbildung 18: Ein Sonogramm | ||

| T: Zeit | A: Amplitude | F: Frequenz |

Heutzutage verwendet man bei elektronischer Tonaufnahme

und Wiedergabe gänzlich künstliche Geräte wie Synthesizer,

um Klänge praktisch aus dem Nichts zu erzeugen, oder Sampler,

um Klänge abzuspeichern und bei verschiedenen Tonhöhen mit

diversen Effekten wiederzugeben. Es ist dann etwa möglich,

ein Cellokonzert so zu spielen, dass man die Originalinstrumente

durch gesampelte "knarrende Stühle" ersetzt. Und das kann

wirklich jeder tun, man muss kein Instrument spielen können.

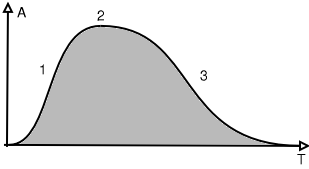

Die Merkmale einer einzelnen Note sind im folgenden Diagramm

gegeben:

| Abbildung 19: Merkmale einer Note: Hüllkurve | |

| 1: Attack | A: Positive Amplitude |

| 2: Sustain | T: Zeit |

| 3: Dämpfung | |

Diese Kurve zeigt die Entwicklung der Gesamtlautstärke eines Tons

über die Zeit. Diese Art Kurve nennt man Hüllkurve, weil es das Signal

(grauer Teil des Signals) einhüllt. Der ansteigende Teil wird "attack"

genannt und kann je nach Instrumenttyp stark variieren. Den zweiten Teil

nennt man "sustain", das ist der Körper des Tons und oft der längste Teil,

abgesehen bei Percussion Instrumenten. Der dritte Teil kann auch je nach

Instrument in Form und Länge variabel sein.

Zudem erlauben Instrumente Musikern, jeden der drei Bereiche zu beeinflussen.

Unterschiedlicher Anschlag der Klaviertasten wird den attack-Bereich des

Tons beeinflussen, während die Pedale die Dämpfung verändern werden.

Jeder der drei Bereiche kann sein individuelles Spektrum haben (Farbe),

die die Möglichkeiten an Klangfarben ins Unendliche steigern.

Harmonische Frequenzen ändern sich nicht im selben Verhältnis. Basstöne

tendieren dazu, länger zu dauern, sodass der Klang am Anfang und am

Schluss des Tons nicht derselbe ist.

Gemäß seiner Definition kann der Frequenzbereich eines Geräts dem Bereich eines Instruments entsprechen. In beiden Fällen beschreibt der Begriff einen Bereich von Frequenzen oder Tonhöhen, den ein Instrument spielen kann. Wie auch immer, der höchste Ton, den ein Instrument spielen kann, entspricht der Grundfrequenz in der obigen Tabelle. Anders gesagt, erfordert das Aufnehmen eines Instruments ein Aufnahmegerät, das einen viel höheren Frequenzbereich hat als die höchste Note, die das Instrument spielen kann - sofern man die Klangfarben mit aufnehmen will. Ein schmaler Frequenzbereich wird all die oberen Frequenzen wie ein Tiefpassfilter wegschneiden und die Klangfülle ändern. In der Praxis braucht das Aufnahmegerät einen Frequenzbereich, der dem des menschlichen Gehörs entspricht, in etwa 20 Hz bis 20 KHz. Oft muss man auch höher als 20 KHz gehen, weil an der oberen Grenze des Frequenzbereichs oft Verzerrungen auftreten.

Wenn man die obige Tabelle mit den Frequenzen betrachtet, wird

man (als Musiker) Ähnlichkeiten zwischen harmonischen Frequenzen

finden und den Noten, die einen Akkord bilden.

Harmonische Frequenzen sind Vielfache der Grundfrequenz.

So sind etwa für ein C 1 bei 32.7 Hz die harmonischen Frequenzen folgende:

| Harmonie | 1 | 2 | 3 | 4 | 5 | 6 | 7 | 8 |

|---|---|---|---|---|---|---|---|---|

| Frequenz | 32,7 | 65,4 | 98,1 | 130,8 | 163.5 | 196,2 | 228,9 | 261,6 |

| Note | C | C | G | C | E | G | B b | C |

Hier sehen wir, warum wir einen Akkord als Tonika (C-E-G-C) oder als Septakkord kennen (C-E-G-Bb): Die Frequenzen der beteiligten Noten schwingen im Einklang mit den harmonischen Frequenzen des Grundtons (C). Darin liegt die Magie.

Ohne zuviel ins Detail zu gehen, haben wir physikalische, biologische und technische Aspekte von Schall und Akustik betrachtet. Unser Ohr ist immer das beste Auswahlkriterium, und wird es auch immer sein. Zahlen, die uns Mathematiker liefern, oder hochentwickelte Messgeräte können uns zwar verstehen helfen, warum eine bestimmte Aufnahme so klingt wie sie klingt. Aber sie werden uns nie sagen können, ob in den 60ern die Beatles oder die Rolling Stones die bessere Musik gemacht haben.

Brüel & Kjaer: Dänische Firma, die Messgeräte für Akustik und Schwingungen herstellt. Dieses Unternehmen publiziert seit langer Zeit (50 Jahreungefähr) frei verfügbare Bücher, aus denen die meisten in diesem Artikel verwendeten Abbildungen stammen. Die Bücher sind im PDF Format frei verfügbar unter http://www.bksv.com/bksv/2148.htm

|

Der LinuxFocus Redaktion schreiben

© John Perr "some rights reserved" see linuxfocus.org/license/ http://www.LinuxFocus.org |

Autoren und Übersetzer:

|

2005-01-14, generated by lfparser_pdf version 2.51